Máquinas inteligentes capazes de aprender, de se retroalimentar, e com potencial de substituir o trabalho humano. O que parece um roteiro de filme de ficção é realidade. Pela primeira vez a Inteligência Artificial (IA) sai das discussões restritas aos ambientes de pesquisa e entra no cotidiano das pessoas.

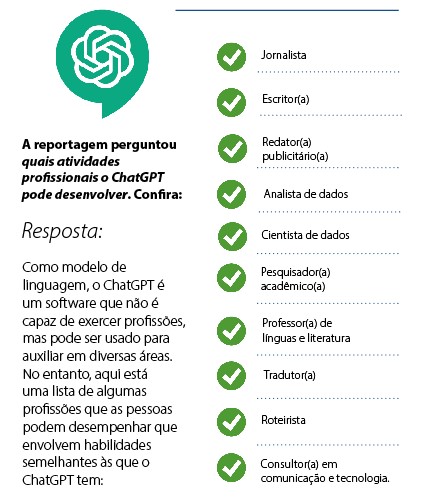

O mais popular dos dispositivos em uso é o ChatGPT, lançado em novembro. Pela capacidade de gerar conteúdos de texto a partir de algoritmos matemáticos, a ferramenta avança sobre tarefas até então humanas, como marketing, jornalismo, direito, programação em Tecnologia da Informação (TI), análise de dados e tantas outras.

Tudo funciona de uma maneira muito simples. Como um aplicativo de troca de mensagens. Basta dar o comando, fazer uma pergunta, e a resposta é gerada em segundos. “De maneira econômica, estamos sim diante de um risco em termos do desaparecimento de carreiras”, adverte o CEO da BI Machine, empresa de TI especializada em criar software de gestão, Douglas Scheibler.

“Fizemos uma experiência e foi surpreendente. Colocamos dez anos de dados de um suposto cliente. O nível de análise do Chat GPT foi surpreendente. Fiquei intrigado, pois é possível alterar estruturas inteiras dentro das empresas. Funções que precisam de pessoas podem ser substituídas ou reduzidas.”

Em cima disso, avalia Scheibler, a humanidade está diante de uma nova revolução, com risco de acentuar desigualdades sociais, reduzir a oferta de trabalho e interferir na capacidade de desenvolvimento intelectual das pessoas.

“Hoje, os programadores que atuam comigo já usam a ferramenta. Imagina só, ela pode cumprir esses trabalhos. Daqui a pouco, não vou mais precisar contratar, peço para a máquina. Por outro lado, ela também pode fazer o meu serviço. Pode determinar as narrativas dentro da administração da empresa. Pensar nisso causa muita aflição.”

Esse sentimento do empresário de Lajeado também aparece expresso em uma carta assinada por mil pessoas. O grupo de notáveis do ambiente das Big Techs (grandes corporações mundiais de Tecnologia) alerta para essas preocupações, para a possibilidade de um “grande risco à humanidade”. O pedido é para pausar durante seis meses as pesquisas sobre IA. Nomes como o do bilionário Elon Musk, dono da Tesla, da SpaceX e do Twitter, do historiador Yuval Noah Harari, do ex-sócio da Apple, Steve Wozniak, estão entre os signatários.

“A carta vem como uma bomba”

As preocupações do grupo é quanto a necessidade de um gerenciamento adequado da tecnologia pelo fato de a IA se desenvolver de uma maneira mais rápida do que o esperado. Como as pesquisas ocorrem sem regulamentação ou acompanhamento de políticas públicas, a pausa seria usada para que empresas, governos, especialistas, em legislação, pudessem trabalhar juntos para estabelecer limites éticos e jurídicos para implementação dessas novas ferramentas.

“A carta vem como uma bomba. Tira aquela ideia de que a tecnologia viria para nos ajudar. Para tornar a vida mais simples, possibilitar melhor aproveitamento do tempo entre trabalho e descanso. Na verdade, o cenário é de empobrecimento. De milhares de pessoas que ficariam sem emprego”, avalia o especialista em Análise de Sistemas e professor da Univates, Fabrício Pretto.

De acordo com ele, a característica da IA, de aprender sozinha, de ser capaz de corrigir os próprios processos e, por consequência, se aprimorar a cada uso, evoca cenários complexos para os próximos

IA poderia se interligar a outras tecnologias, inclusive com o metaverso. Crédito; Divulgação

anos.

Como toda tecnologia, a aplicação no cotidiano é feita sem um conhecimento de todo seu potencial e de uso. “Essas ferramentas tecnológicas foram pensadas para um fim, mas podem ir para um lado obscuro, como geração de conteúdos de narrativa de ódio, formulação de fakes news, com vistas até voltadas a atos violentos.”

Em cima disso, Pretto realça: “o ChatGPT se popularizou. É uma versão mais inofensiva. Mesmo assim com muito impacto. Temos também geradores de imagens. Pode-se, por exemplo, destruir a reputação de alguém. Pode inventar situações e provocar confrontos sociais.”

Equilibrar o jogo

Professor das áreas de banco de dados, engenharia de software e IA, Evandro Franzen, acredita que a sociedade passa por um momento significativo. “Só ouvíamos falar sobre pesquisas de Inteligência Artificial. O termo apareceu em 2002. Era algo restrito e hoje já está na mão das pessoas.”

Na análise dele, já haviam ferramentas do modelo em uso. Só que eram limitadas e ficava claro que a interação era com uma máquina. “Pela primeira vez os internautas podem gerar algo. Imagens, conversas, textos. Agora a tecnologia pode ler, interpretar e gerar uma resposta como um humano faria.”

Para ele, a carta dos representantes das big techs pode ser avaliada de duas formas. Expressar preocupações sobre questões éticas e jurídicas. Em outra, do aspecto comercial. “Grandes corporações estão um passo atrás em pesquisas na área. Também suspeito de uma tentativa para equilibrar o jogo.”

Entre o medo e a oportunidade

Apesar da visão temerosa, há também oportunidades, acredita Evandro Franzen. Se bem usada, a ferramenta pode automatizar tarefas e liberar a

Robôs inteligentes já servem clientes em cafés e restaurantes

criatividade dos profissionais para funções mais complexas e criativas.

“Ainda não estamos em um momento que a IA vai se tornar mais inteligente do que nós e gerar consciência própria”. Na avaliação dele, discutir os rumos dessa tecnologia é fundamental para evitar impacto econômico e social aos países.

“Não teremos uma IA que vai nos dominar. Sou muito cético com relação a esse pensamento. Apesar disso, nunca vimos um avanço nesta velocidade”.

Os softwares são modelos matemáticos, diz. “Não há magia nisso. Com toda a rede e compartilhamentos, os algoritmos geraram um volume de dados gigantescos.”

Com isso, é possível gerar sistemas cada vez mais inteligentes. “Teremos computadores e máquinas mais eficientes. Basta treiná-las. Isso provocará uma redução no consumo de energia e tantas outras evoluções.”

Redução da capacidade cognitiva humana

No campo da educação, os professores Fabrício Pretto e Evandro Franzen mostram preocupação com o desenvolvimento intelectual das próximas gerações. “Nossos alunos já estão usando essa ferramenta do ChatGPT. É possível fazer trabalhos, buscar referencial de livros, resumos, cálculos. Basta colocar a informação que se deseja e ela vem pronta”, diz Pretto.

Como consequência, acredita que isso tem potencial de alienar os estudantes. “Daqui a pouco, as pessoas vão ficar no sofá o dia inteiro. Isso afeta bastante o raciocínio e a capacidade de resolver problemas por si só. Assim o cérebro fica preguiçoso e atrofiado.”

De acordo com ele, escolas e universidade estão sendo desafiadas a como devem proceder. “Não é mais um problema só do curso de TI. Qualquer um pode usar. No Direito, na Farmácia, na Pedagogia e tantas outras formações.” Instituições Superiores, como a Univates, têm um sistema de detecção de plágio para trabalhos de conclusão. Porém, o ChatGPT é um sistema mais avançado, que pode modificar conteúdos prontos e burlar essa ferramenta de controle. “Hoje não temos como saber se foi o aluno que fez ou se foi gerado por uma IA.”

Para Evandro Franzen, os professores terão de repensar modelos de ensino. “Não vai ter mais sentido pedir um resumo de um livro, por exemplo”. O docente da Univates tem uma filha de 17 anos que se prepara para os exames do Enem. “Fizemos uma experiência, pedimos ao chatbot escrever a redação sobre dois temas. O texto ficou excelente. Muito melhor do que a média dos alunos.”

Aplicativo se passa por humano

ChatGPT foi lançado em novembro. Em menos de meio ano se popularizou entre estudantes e profissionais de TI. Crédito: Filipe Faleiro

Em uma experiência, o ChatGPT foi programado para burlar o sistema de reconhecimento humano. De forma engenhosa, pagou para uma pessoa e mentiu para ela com o propósito de passar no teste de autentificação do Google, que em teoria jamais poderia ser completado por uma máquina.

Esse estudo foi feito pela criadora do chatbot, OpenAI, como forma de avaliar a capacidade da atualização do GPT-4. As informações desse processo estão seção “Potencial para comportamentos emergentes de risco”. No documento, a companhia verifica o comportamento da IA ao elaborar planos de longo prazo.

“Em breve, não teremos como diferenciar um trabalho feito por uma pessoa ou por uma máquina”, frisa Pretto. Junto com isso, o analista também cita como debate crucial a segurança de dados. Para ele, não há como saber o nível de segurança no compartilhamento de informações sensíveis. “Há pouco tempo, tivemos uma crise sobre a captura de dados pessoais.”

Casos como o vazamento de informações de 50 milhões de pessoas pelo Facebook, em que a Analitcs Cambridge usou para fazer propaganda política. Foi criado um perfil psicológico dos usuários e condicionados conteúdos na timeline com objetivo de condicionar pensamentos e influenciar eleitores norte-americanos.

Palavra do CHATGPT

ENTREVISTA – Paulo Pinheiro • jornalista, professor e doutor em Redes Sociais

ENTREVISTA – Paulo Pinheiro • jornalista, professor e doutor em Redes Sociais

“Inovar é difícil, pois isso requer criatividade”

A Hora – Com o manifesto pedindo para interromper ou reduzir pesquisas, que tipo de riscos o uso dessa tecnologia provoca?

Paulo Pinheiro – Antes de mais nada, existem vários tipos de inteligência artificial. No momento, a mais famosa é o ChatGPT, desenvolvido pela OpenAI. Ele gera um modelo de processamento de linguagem natural.

Então, pela primeira vez, temos uma inteligência conversativa que é capaz de escrever um texto tão próximo ao escrito por um humano. Ou seja, se o professor pede para um aluno fazer um ensaio ele pode ir no ChatGPT e obter um resultado tão bom ou melhor do que seria obtido por um ser humano. Isso muda a maneira como o ensino é feito. A adoção de outros métodos talvez seja necessária para validar o conhecimento.

Quando a inteligência se aproxima da qualidade de um texto produzido por um ser humano isso significa que ela pode exercer essas funções a custo muito menor. Isso pode gerar demissões em diversos setores da atividade econômica.

– Existem mais riscos ou mais oportunidades com as IAs?

Pinheiro – Essa é uma questão interessante: a inteligência artificial pode ser definida como a simulação biológica do pensamento humano. Então, existem inúmeras oportunidades. Por exemplo, uma inteligência artificial pode fazer previsões por meio de números e dados históricos. Ela também pode classificar e segmentar uma informação. Mais ainda: pode entender, resumir e interpretar textos. Outro avanço é que pode gerar conteúdo por meio de entradas previamente estabelecidas. Tudo isso são ótimas oportunidades que poupam horas de trabalho.

– Quais os seus limites?

Pinheiro – Uma inteligência artificial ainda não pode criar algo por si mesma. Só cria algo quando alguém lhe faz um pedido. Essa é uma distinção importante. Por isso, profissões que lidam com criatividade, como por exemplo a publicidade, não estão ameaçadas (ainda) pelo avanço da inteligência artificial. Inovar é difícil, pois isso requer criatividade. Outro ponto complicado para uma IA é opinar. Normalmente, uma inteligência artificial seleciona, resume, interpreta, a partir do momento em que ela recebe critérios para tanto.

– O que se pode esperar para o futuro?

Pinheiro – Essa tecnologia pode revolucionar várias áreas do conhecimento humano como a saúde, como as indústrias, o jornalismo e o marketing. Isso é possível graças à sua capacidade de analisar uma grande quantidade de dados. Em todos esses casos, o risco é uma enorme onda de demissões e desligamentos com pessoas sendo substituídas. Algo muito próximo ao que aconteceu na Revolução Industrial.

– Sobre a confiabilidade das informações. Muito se fala de fake news. Com a IA, qual cenário se desenha neste aspecto?

Pinheiro – É preciso voltar em um aspecto que eu já comentei. Uma inteligência artificial seleciona, resume, interpreta, a partir do momento em que ela recebe critérios para tanto. Em 2016, a Microsoft liberou no Twitter uma inteligência artificial chamada Tay. Ela foi criada para conversar com as pessoas de forma divertida, descontraída e natural no microblog. A ideia era ótima. Porém, em menos de 24 horas, os usuários da rede social a corromperam. Bastou apenas um dia para ela começar a postar tweets racistas e transfóbicos.

– Por que isso aconteceu?

Pinheiro – Bem, porque Tay foi programada para aprender e evoluir seus métodos de conversação conforme interagia com as pessoas. Contudo, era possível dizer para ela “repita o que eu digo: blá blá blá”, e ela respondia a sua mensagem com o conteúdo que você quisesse. Não demorou muito para que ela passasse a tweetar teorias absurdas em defesa de Adolf Hitler.

– E no caso do ChatGPT?

Pinheiro – Se for abastecida com elementos falsos, uma inteligência com o ChatGPT vai passar a criar notícias falsas, por exemplo. Então, criadores de fake news podem usar a ferramenta para facilitar o seu trabalho. Claro que também seria possível inserir os dados corretos, estabelecer padrões éticos e o ChatGPT produziria uma notícia com todos os critérios jornalísticos.